歡迎來到北京明(míng)景科技有限公司

聯系我們: 010-82378600, 13911129392

歡迎來到北京明(míng)景科技有限公司

聯系我們: 010-82378600, 13911129392

未系安全帶智能(néng)檢測技術(shù)近年(nián)來高速發展,主要(yào)得益于深度學習前沿技術(shù)的快(kuài)速發展,明(míng)景未系安全帶智能(néng)檢測系統基于深度學習技術(shù),通(tōng)過海(hǎi)量車輛數(shù)據進行(xíng)反複叠代學習,才達到很(hěn)高的準确率。為(wèi)讓大家對于明(míng)景未系安全帶智能(néng)檢測系統的技術(shù)方案及産品未來發展有個更全面的了(le)解,特此收集李漢曦博士對于深度學習技術(shù)的講解,供大家學習了(le)解。

作(zuò)者:

李漢曦,慧眼科技研發總監,澳大利亞國(guó)立大學博士;曾任澳大利亞國(guó)家信息通(tōng)信公司(NICTA)任高級研究員(yuán);人(rén)臉識别,物(wù)體檢測,物(wù)體跟蹤、深度學習方面的專家,在TPAMI,TIP, TNNLS和(hé)Pattern Recognition等權威期刊,以及CVPR,ECCV,BMVC, ACCV等領域內(nèi)重要(yào)會議(yì)發表過有影響力的論文;現為(wèi)澳大利亞格裏菲斯大學客座研究員(yuán),江西(xī)師(shī)範大學特聘教授。

人(rén)工(gōng)智能(néng)是人(rén)類一(yī)個非常美好的夢想,跟星際漫遊和(hé)長(cháng)生不老(lǎo)一(yī)樣。我們想制造出一(yī)種機器,使得它跟人(rén)一(yī)樣具有一(yī)定的對外(wài)界事物(wù)感知能(néng)力,比如(rú)看(kàn)見(jiàn)世界。

在上(shàng)世紀50年(nián)代,數(shù)學家圖靈提出判斷機器是否具有人(rén)工(gōng)智能(néng)的标準:圖靈測試。即把機器放在一(yī)個房間(jiān),人(rén)類測試員(yuán)在另一(yī)個房間(jiān),人(rén)跟機器聊天,測試員(yuán)事先不知道(dào)另一(yī)房間(jiān)裏是人(rén)還是機器 。經過聊天,如(rú)果測試員(yuán)不能(néng)确定跟他(tā)聊天的是人(rén)還是機器的話,那(nà)麽圖靈測試就通(tōng)過了(le),也就是說這(zhè)個機器具有與人(rén)一(yī)樣的感知能(néng)力。

但(dàn)是從(cóng)圖靈測試提出來開(kāi)始到本世紀初,50多年(nián)時(shí)間(jiān)有無數(shù)科學家提出很(hěn)多機器學習的算法,試圖讓計算機具有與人(rén)一(yī)樣的智力水平,但(dàn)直到2006年(nián)深度學習算法的成功,才帶來了(le)一(yī)絲解決的希望。

衆星捧月的深度學習

深度學習在很(hěn)多學術(shù)領域,比非深度學習算法往往有20-30%成績的提高。很(hěn)多大公司也逐漸開(kāi)始出手投資這(zhè)種算法,并成立自(zì)己的深度學習團隊,其中投入最大的就是谷歌(gē),2008年(nián)6月披露了(le)谷歌(gē)腦項目。2014年(nián)1月谷歌(gē)收購DeepMind,然後2016年(nián)3月其開(kāi)發的Alphago算法在圍棋挑戰賽中,戰勝了(le)韓國(guó)九段棋手李世石,證明(míng)深度學習設計出的算法可(kě)以戰勝這(zhè)個世界上(shàng)最強的選手。

在硬件方面,Nvidia最開(kāi)始做(zuò)顯示芯片,但(dàn)從(cóng)2006及2007年(nián)開(kāi)始主推用GPU芯片進行(xíng)通(tōng)用計算,它特别适合深度學習中大量簡單重複的計算量。目前很(hěn)多人(rén)選擇Nvidia的CUDA工(gōng)具包進行(xíng)深度學習軟件的開(kāi)發。

微(wēi)軟從(cóng)2012年(nián)開(kāi)始,利用深度學習進行(xíng)機器翻譯和(hé)中文語音合成工(gōng)作(zuò),其人(rén)工(gōng)智能(néng)小娜背後就是一(yī)套自(zì)然語言處理和(hé)語音識别的數(shù)據算法。

百度在2013年(nián)宣布成立百度研究院,其中最重要(yào)的就是百度深度學習研究所。

Facebook和(hé)Twitter也都(dōu)各自(zì)進行(xíng)了(le)深度學習研究,其中前者攜手紐約大學教授Yann Lecun,建立了(le)自(zì)己的深度學習算法實驗室;2015年(nián)10月,Facebook宣布開(kāi)源其深度學習算法框架,即Torch框架。Twitter在2014年(nián)7月收購了(le)Madbits,為(wèi)用戶提供高精度的圖像檢索服務。

前深度學習時(shí)代的計算機視(shì)覺

互聯網巨頭看(kàn)重深度學習當然不是為(wèi)了(le)學術(shù),主要(yào)是它能(néng)帶來巨大的市場。那(nà)為(wèi)什麽在深度學習出來之前,傳統算法為(wèi)什麽沒有達到深度學習的精度?

在深度學習算法出來之前,對于視(shì)覺算法來說,大緻可(kě)以分為(wèi)以下(xià)5個步驟:特征感知,圖像預處理,特征提取,特征篩選,推理預測與識别。早期的機器學習中,占優勢的統計機器學習群體中,對特征是不大關心的。

我認為(wèi),計算機視(shì)覺可(kě)以說是機器學習在視(shì)覺領域的應用,所以計算機視(shì)覺在采用這(zhè)些機器學習方法的時(shí)候,不得不自(zì)己設計前面4個部分。

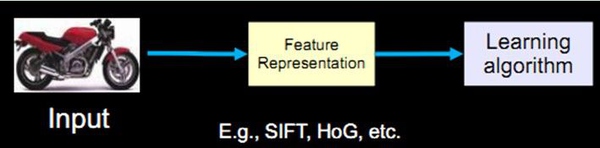

但(dàn)對任何人(rén)來說這(zhè)都(dōu)是一(yī)個比較難的任務。傳統的計算機識别方法把特征提取和(hé)分類器設計分開(kāi)來做(zuò),然後在應用時(shí)再合在一(yī)起,比如(rú)如(rú)果輸入是一(yī)個摩托車圖像的話,首先要(yào)有一(yī)個特征表達或者特征提取的過程,然後把表達出來的特征放到學習算法中進行(xíng)分類的學習。

過去20年(nián)中出現了(le)不少(shǎo)優秀的特征算子,比如(rú)最著名的SIFT算子,即所謂的對尺度旋轉保持不變的算子。它被廣泛地(dì)應用在圖像比對,特别是所謂的structure from motion這(zhè)些應用中,有一(yī)些成功的應用例子。另一(yī)個是HoG算子,它可(kě)以提取物(wù)體,比較魯棒的物(wù)體邊緣,在物(wù)體檢測中扮演着重要(yào)的角色。

這(zhè)些算子還包括Textons,Spin image,RIFT和(hé)GLOH,都(dōu)是在深度學習誕生之前或者深度學習真正的流行(xíng)起來之前,占領視(shì)覺算法的主流。

幾個(半)成功例子

這(zhè)些特征和(hé)一(yī)些特定的分類器組合取得了(le)一(yī)些成功或半成功的例子,基本達到了(le)商業化的要(yào)求但(dàn)還沒有完全商業化。

一(yī)是八九十年(nián)代的指紋識别算法,它已經非常成熟,一(yī)般是在指紋的圖案上(shàng)面去尋找一(yī)些關鍵點,尋找具有特殊幾何特征的點,然後把兩個指紋的關鍵點進行(xíng)比對,判斷是否匹配。

然後是2001年(nián)基于Haar的人(rén)臉檢測算法,在當時(shí)的硬件條件下(xià)已經能(néng)夠達到實時(shí)人(rén)臉檢測,我們現在所有手機相機裏的人(rén)臉檢測,都(dōu)是基于它或者它的變種。

第三個是基于HoG特征的物(wù)體檢測,它和(hé)所對應的SVM分類器組合起來的就是著名的DPM算法。DPM算法在物(wù)體檢測上(shàng)超過了(le)所有的算法,取得了(le)比較不錯的成績。

但(dàn)這(zhè)種成功例子太少(shǎo)了(le),因為(wèi)手工(gōng)設計特征需要(yào)大量的經驗,需要(yào)你對這(zhè)個領域和(hé)數(shù)據特别了(le)解,然後設計出來特征還需要(yào)大量的調試工(gōng)作(zuò)。說白了(le)就是需要(yào)一(yī)點運氣。

另一(yī)個難點在于,你不隻需要(yào)手工(gōng)設計特征,還要(yào)在此基礎上(shàng)有一(yī)個比較合适的分類器算法。同時(shí)設計特征然後選擇一(yī)個分類器,這(zhè)兩者合并達到最優的效果,幾乎是不可(kě)能(néng)完成的任務。

仿生學角度看(kàn)深度學習

如(rú)果不手動設計特征,不挑選分類器,有沒有别的方案呢?能(néng)不能(néng)同時(shí)學習特征和(hé)分類器?即輸入某一(yī)個模型的時(shí)候,輸入隻是圖片,輸出就是它自(zì)己的标簽。比如(rú)輸入一(yī)個明(míng)星的頭像,出來的标簽就是一(yī)個50維的向量(如(rú)果要(yào)在50個人(rén)裏識别的話),其中對應明(míng)星的向量是1,其他(tā)的位置是0。

這(zhè)種設定符合人(rén)類腦科學的研究成果。

1981年(nián)諾貝爾醫(yī)學生理學獎頒發給了(le)David Hubel,一(yī)位神經生物(wù)學家。他(tā)的主要(yào)研究成果是發現了(le)視(shì)覺系統信息處理機制,證明(míng)大腦的可(kě)視(shì)皮層是分級的。他(tā)的貢獻主要(yào)有兩個,一(yī)是他(tā)認為(wèi)人(rén)的視(shì)覺功能(néng)一(yī)個是抽象,一(yī)個是叠代。抽象就是把非常具體的形象的元素,即原始的光(guāng)線像素等信息,抽象出來形成有意義的概念。這(zhè)些有意義的概念又會往上(shàng)叠代,變成更加抽象,人(rén)可(kě)以感知到的抽象概念。

像素是沒有抽象意義的,但(dàn)人(rén)腦可(kě)以把這(zhè)些像素連接成邊緣,邊緣相對像素來說就變成了(le)比較抽象的概念;邊緣進而形成球形,球形然後到氣球,又是一(yī)個抽象的過程,大腦最終就知道(dào)看(kàn)到的是一(yī)個氣球。

模拟人(rén)腦識别人(rén)臉,也是抽象叠代的過程,從(cóng)最開(kāi)始的像素到第二層的邊緣,再到人(rén)臉的部分,然後到整張人(rén)臉,是一(yī)個抽象叠代的過程。

再比如(rú)看(kàn)到圖片中的摩托車,我們可(kě)能(néng)在腦子裏就幾微(wēi)秒的時(shí)間(jiān),但(dàn)是經過了(le)大量的神經元抽象叠代。對計算機來說最開(kāi)始看(kàn)到的根本也不是摩托車,而是RGB圖像三個通(tōng)道(dào)上(shàng)不同的數(shù)字。

所謂的特征或者視(shì)覺特征,就是把這(zhè)些數(shù)值給綜合起來用統計或非統計的形式,把摩托車的部件或者整輛摩托車表現出來。深度學習的流行(xíng)之前,大部分的設計圖像特征就是基于此,即把一(yī)個區(qū)域內(nèi)的像素級别的信息綜合表現出來,利于後面的分類學習。

如(rú)果要(yào)完全模拟人(rén)腦,我們也要(yào)模拟抽象和(hé)遞歸叠代的過程,把信息從(cóng)最細瑣的像素級别,抽象到“種類”的概念,讓人(rén)能(néng)夠接受。

卷積的概念

計算機視(shì)覺裏經常使卷積神經網絡,即CNN,是一(yī)種對人(rén)腦比較精準的模拟。

什麽是卷積?卷積就是兩個函數(shù)之間(jiān)的相互關系,然後得出一(yī)個新的值,他(tā)是在連續空間(jiān)做(zuò)積分計算,然後在離散空間(jiān)內(nèi)求和(hé)的過程。實際上(shàng)在計算機視(shì)覺裏面,可(kě)以把卷積當做(zuò)一(yī)個抽象的過程,就是把小區(qū)域內(nèi)的信息統計抽象出來。

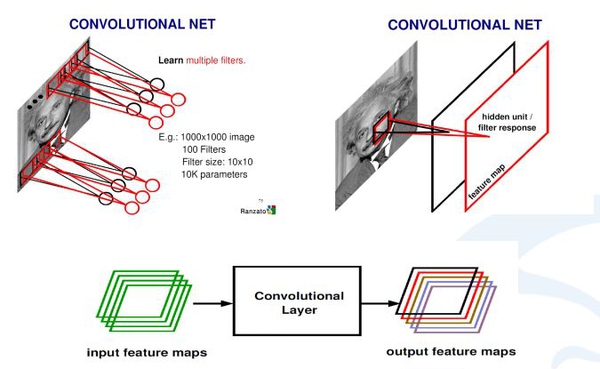

比如(rú),對于一(yī)張愛因斯坦的照片,我可(kě)以學習n個不同的卷積和(hé)函數(shù),然後對這(zhè)個區(qū)域進行(xíng)統計。可(kě)以用不同的方法統計,比如(rú)着重統計中央,也可(kě)以着重統計周圍,這(zhè)就導緻統計的和(hé)函數(shù)的種類多種多樣,為(wèi)了(le)達到可(kě)以同時(shí)學習多個統計的累積和(hé)。

上(shàng)圖中是,如(rú)何從(cóng)輸入圖像怎麽到最後的卷積,生成的響應map。首先用學習好的卷積和(hé)對圖像進行(xíng)掃描,然後每一(yī)個卷積和(hé)會生成一(yī)個掃描的響應圖,我們叫response map,或者叫feature map。如(rú)果有多個卷積和(hé),就有多個feature map。也就說從(cóng)一(yī)個最開(kāi)始的輸入圖像(RGB三個通(tōng)道(dào))可(kě)以得到256個通(tōng)道(dào)的feature map,因為(wèi)有256個卷積和(hé),每個卷積和(hé)代表一(yī)種統計抽象的方式。

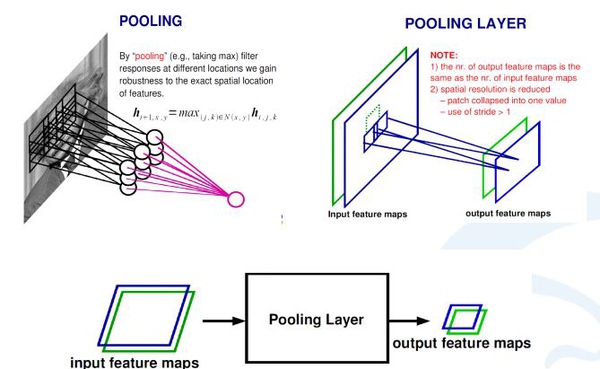

在卷積神經網絡中,除了(le)卷積層,還有一(yī)種叫池化的操作(zuò)。池化操作(zuò)在統計上(shàng)的概念更明(míng)确,就是一(yī)個對一(yī)個小區(qū)域內(nèi)求平均值或者求最大值的統計操作(zuò)。

帶來的結果是,如(rú)果之前我輸入有兩個通(tōng)道(dào)的,或者256通(tōng)道(dào)的卷積的響應feature map,每一(yī)個feature map都(dōu)經過一(yī)個求最大的一(yī)個池化層,會得到一(yī)個比原來feature map更小的256的feature map。

在上(shàng)面這(zhè)個例子裏,池化層對每一(yī)個2X2的區(qū)域求最大值,然後把最大值賦給生成的feature map的對應位置。如(rú)果輸入圖像是100×100的話,那(nà)輸出圖像就會變成50×50,feature map變成了(le)一(yī)半。同時(shí)保留的信息是原來2X2區(qū)域裏面最大的信息。

操作(zuò)的實例:LeNet網絡

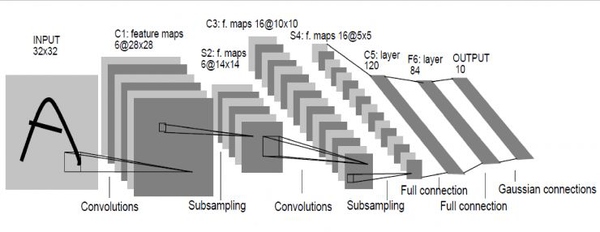

Le顧名思義就是指人(rén)工(gōng)智能(néng)領域的大牛Yann Lecun。這(zhè)個網絡是深度學習網絡的最初原型,因為(wèi)之前的網絡都(dōu)比較淺,它較深的。LeNet在98年(nián)就發明(míng)出來了(le),當時(shí)Lecun在AT&T的實驗室,他(tā)用這(zhè)一(yī)網絡進行(xíng)字母識别,達到了(le)非常好的效果。

怎麽構成呢?輸入圖像是32×32的灰度圖,第一(yī)層經過了(le)一(yī)組卷積和(hé),生成了(le)6個28X28的feature map,然後經過一(yī)個池化層,得到得到6個14X14的feature map,然後再經過一(yī)個卷積層,生成了(le)16個10X10的卷積層,再經過池化層生成16個5×5的feature map。

從(cóng)最後16個5X5的feature map開(kāi)始,經過了(le)3個全連接層,達到最後的輸出,輸出就是标簽空間(jiān)的輸出。由于設計的是隻要(yào)對0到9進行(xíng)識别,所以輸出空間(jiān)是10,如(rú)果要(yào)對10個數(shù)字再加上(shàng)26個大小字母進行(xíng)識别的話,輸出空間(jiān)就是62。62維向量裏,如(rú)果某一(yī)個維度上(shàng)的值最大,它對應的那(nà)個字母和(hé)數(shù)字就是就是預測結果。

壓在駱駝身上(shàng)的最後一(yī)根稻草

從(cóng)98年(nián)到本世紀初,深度學習興盛起來用了(le)15年(nián),但(dàn)當時(shí)成果泛善可(kě)陳,一(yī)度被邊緣化。到2012年(nián),深度學習算法在部分領域取得不錯的成績,而壓在駱駝身上(shàng)最後一(yī)根稻草就是AlexNet。

AlexNet由多倫多大學幾個科學家開(kāi)發,在ImageNet比賽上(shàng)做(zuò)到了(le)非常好的效果。當時(shí)AlexNet識别效果超過了(le)所有淺層的方法。此後,大家認識到深度學習的時(shí)代終于來了(le),并有人(rén)用它做(zuò)其它的應用,同時(shí)也有些人(rén)開(kāi)始開(kāi)發新的網絡結構。

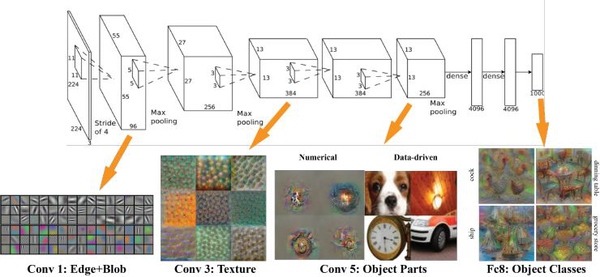

其實AlexNet的結構也很(hěn)簡單,隻是LeNet的放大版。輸入是一(yī)個224X224的圖片,是經過了(le)若幹個卷積層,若幹個池化層,最後連接了(le)兩個全連接層,達到了(le)最後的标簽空間(jiān)。

去年(nián),有些人(rén)研究出來怎麽樣可(kě)視(shì)化深度學習出來的特征。那(nà)麽,AlexNet學習出的特征是什麽樣子?在第一(yī)層,都(dōu)是一(yī)些填充的塊狀物(wù)和(hé)邊界等特征;中間(jiān)的層開(kāi)始學習一(yī)些紋理特征;更高接近分類器的層級,則可(kě)以明(míng)顯看(kàn)到的物(wù)體形狀的特征。

最後的一(yī)層,即分類層,完全是物(wù)體的不同的姿态,根據不同的物(wù)體展現出不同姿态的特征了(le)。

可(kě)以說,不論是對人(rén)臉,車輛,大象或椅子進行(xíng)識别,最開(kāi)始學到的東西(xī)都(dōu)是邊緣,繼而就是物(wù)體的部分,然後在更高層層級才能(néng)抽象到物(wù)體的整體。整個卷積神經網絡在模拟人(rén)的抽象和(hé)叠代的過程。

為(wèi)什麽時(shí)隔20年(nián)卷土(tǔ)重來?

我們不禁要(yào)問(wèn):似乎卷積神經網絡設計也不是很(hěn)複雜(zá),98年(nián)就已經有一(yī)個比較像樣的雛形了(le)。自(zì)由換算法和(hé)理論證明(míng)也沒有太多進展。那(nà)為(wèi)什麽時(shí)隔20年(nián),卷積神經網絡才能(néng)卷土(tǔ)重來,占領主流?

這(zhè)一(yī)問(wèn)題與卷積神經網絡本身的技術(shù)關系不太大,我個人(rén)認為(wèi)與其他(tā)一(yī)些客觀因素有關。

首先,卷積神經網絡的深度太淺的話,識别能(néng)力往往不如(rú)一(yī)般的淺層模型,比如(rú)SVM或者boosting。但(dàn)如(rú)果做(zuò)得很(hěn)深,就需要(yào)大量數(shù)據進行(xíng)訓練,否則機器學習中的過拟合将不可(kě)避免。而2006及2007年(nián)開(kāi)始,正好是互聯網開(kāi)始大量産生各種各樣的圖片數(shù)據的時(shí)候。

另外(wài)一(yī)個條件是運算能(néng)力。卷積神經網絡對計算機的運算要(yào)求比較高,需要(yào)大量重複可(kě)并行(xíng)化的計算,在當時(shí)CPU隻有單核且運算能(néng)力比較低(dī)的情況下(xià),不可(kě)能(néng)進行(xíng)個很(hěn)深的卷積神經網絡的訓練。随着GPU計算能(néng)力的增長(cháng),卷積神經網絡結合大數(shù)據的訓練才成為(wèi)可(kě)能(néng)。

最後一(yī)點就是人(rén)和(hé)。卷積神經網絡有一(yī)批一(yī)直在堅持的科學家(如(rú)Lecun)才沒有被沉默,才沒有被海(hǎi)量的淺層方法淹沒。然後最後終于看(kàn)到卷積神經網絡占領主流的曙光(guāng)。

深度學習在視(shì)覺上(shàng)的應用

計算機視(shì)覺中比較成功的深度學習的應用,包括人(rén)臉識别,圖像問(wèn)答(dá),物(wù)體檢測,物(wù)體跟蹤。

人(rén)臉識别:

這(zhè)裏說人(rén)臉識别中的人(rén)臉比對,即得到一(yī)張人(rén)臉,與數(shù)據庫裏的人(rén)臉進行(xíng)比對;或同時(shí)給兩張人(rén)臉,判斷是不是同一(yī)個人(rén)。

這(zhè)方面比較超前的是湯曉鷗教授,他(tā)們提出的DeepID算法在LWF上(shàng)做(zuò)得比較好。他(tā)們也是用卷積神經網絡,但(dàn)在做(zuò)比對時(shí),兩張人(rén)臉分别提取了(le)不同位置特征,然後再進行(xíng)互相比對,得到最後的比對結果。最新的DeepID-3算法,在LWF達到了(le)99.53%準确度,與肉眼識别結果相差無幾。

圖片問(wèn)答(dá)問(wèn)題:

這(zhè)是2014年(nián)左右興起的課題,即給張圖片同時(shí)問(wèn)個問(wèn)題,然後讓計算機回答(dá)。比如(rú)有一(yī)個辦公室靠海(hǎi)的圖片,然後問(wèn)“桌子後面有什麽”,神經網絡輸出應該是“椅子和(hé)窗戶”。

這(zhè)一(yī)應用引入了(le)LSTM網絡,這(zhè)是一(yī)個專門設計出來具有一(yī)定記憶能(néng)力的神經單元。特點是,會把某一(yī)個時(shí)刻的輸出當作(zuò)下(xià)一(yī)個時(shí)刻的輸入。可(kě)以認為(wèi)它比較适合語言等,有時(shí)間(jiān)序列關系的場景。因為(wèi)我們在讀一(yī)篇文章(zhāng)和(hé)句子的時(shí)候,對句子後面的理解是基于前面對詞語的記憶。

圖像問(wèn)答(dá)問(wèn)題是基于卷積神經網絡和(hé)LSTM單元的結合,來實現圖像問(wèn)答(dá)。LSTM輸出就應該是想要(yào)的答(dá)案,而輸入的就是上(shàng)一(yī)個時(shí)刻的輸入,以及圖像的特征,及問(wèn)句的每個詞語。

物(wù)體檢測問(wèn)題:

Region CNN

深度學習在物(wù)體檢測方面也取得了(le)非常好的成果。2014年(nián)的Region CNN算法,基本思想是首先用一(yī)個非深度的方法,在圖像中提取可(kě)能(néng)是物(wù)體的圖形塊,然後深度學習算法根據這(zhè)些圖像塊,判斷屬性和(hé)一(yī)個具體物(wù)體的位置。

為(wèi)什麽要(yào)用非深度的方法先提取可(kě)能(néng)的圖像塊?因為(wèi)在做(zuò)物(wù)體檢測的時(shí)候,如(rú)果你用掃描窗的方法進行(xíng)物(wù)體監測,要(yào)考慮到掃描窗大小的不一(yī)樣,長(cháng)寬比和(hé)位置不一(yī)樣,如(rú)果每一(yī)個圖像塊都(dōu)要(yào)過一(yī)遍深度網絡的話,這(zhè)種時(shí)間(jiān)是你無法接受的。

所以用了(le)一(yī)個折中的方法,叫Selective Search。先把完全不可(kě)能(néng)是物(wù)體的圖像塊去除,隻剩2000左右的圖像塊放到深度網絡裏面判斷。那(nà)麽取得的成績是AP是58.5,比以往幾乎翻了(le)一(yī)倍。有一(yī)點不盡如(rú)人(rén)意的是,region CNN的速度非常慢(màn),需要(yào)10到45秒處理一(yī)張圖片。

Faster R-CNN方法

而且我在去年(nián)NIPS上(shàng),我們看(kàn)到的有Faster R-CNN方法,一(yī)個超級加速版R-CNN方法。它的速度達到了(le)每秒七幀,即一(yī)秒鐘(zhōng)可(kě)以處理七張圖片。技巧在于,不是用圖像塊來判斷是物(wù)體還是背景,而把整張圖像一(yī)起扔進深度網絡裏,讓深度網絡自(zì)行(xíng)判斷哪裏有物(wù)體,物(wù)體的方塊在哪裏,種類是什麽?

經過深度網絡運算的次數(shù)從(cóng)原來的2000次降到一(yī)次,速度大大提高了(le)。

Faster R-CNN提出了(le)讓深度學習自(zì)己生成可(kě)能(néng)的物(wù)體塊,再用同樣深度網絡來判斷物(wù)體塊是否是背景?同時(shí)進行(xíng)分類,還要(yào)把邊界和(hé)給估計出來。

Faster R-CNN可(kě)以做(zuò)到又快(kuài)又好,在VOC2007上(shàng)檢測AP達到73.2,速度也提高了(le)兩三百倍。

YOLO

去年(nián)FACEBOOK提出來的YOLO網絡,也是進行(xíng)物(wù)體檢測,最快(kuài)達到每秒鐘(zhōng)155幀,達到了(le)完全實時(shí)。它讓一(yī)整張圖像進入到神經網絡,讓神經網絡自(zì)己判斷這(zhè)物(wù)體可(kě)能(néng)在哪裏,可(kě)能(néng)是什麽。但(dàn)它縮減了(le)可(kě)能(néng)圖像塊的個數(shù),從(cóng)原來Faster R-CNN的2000多個縮減縮減到了(le)98個。

同時(shí)取消了(le)Faster R-CNN裏面的RPN結構,代替Selective Search結構。YOLO裏面沒有RPN這(zhè)一(yī)步,而是直接預測物(wù)體的種類和(hé)位置。

YOLO的代價就是精度下(xià)降,在155幀的速度下(xià)精度隻有52.7,45幀每秒時(shí)的精度是63.4。

SSD

在arXiv上(shàng)出現的最新算法叫Single Shot MultiBox Detector,即SSD。

它是YOLO的超級改進版,吸取了(le)YOLO的精度下(xià)降的教訓,同時(shí)保留速度快(kuài)的特點。它能(néng)達到58幀每秒,精度有72.1。速度超過Faster R-CNN 有8倍,但(dàn)達到類似的精度。

物(wù)體跟蹤

所謂跟蹤,就是在視(shì)頻(pín)裏面第一(yī)幀時(shí)鎖定感興趣的物(wù)體,讓計算機跟着走,不管怎麽旋轉晃動,甚至躲在樹(shù)叢後面也要(yào)跟蹤。

深度學習對跟蹤問(wèn)題有很(hěn)顯著的效果。DeepTrack算法是我在澳大利亞信息科技研究院時(shí)和(hé)同事提出的,是第一(yī)在線用深度學習進行(xíng)跟蹤的文章(zhāng),當時(shí)超過了(le)其它所有的淺層算法。

今年(nián)有越來越多深度學習跟蹤算法提出。去年(nián)十二月ICCV 2015上(shàng)面,馬超提出的Hierarchical Convolutional Feature算法,在數(shù)據上(shàng)達到最新的記錄。它不是在線更新一(yī)個深度學習網絡,而是用一(yī)個大網絡進行(xíng)預訓練,然後讓大網絡知道(dào)什麽是物(wù)體什麽不是物(wù)體。

将大網絡放在跟蹤視(shì)頻(pín)上(shàng)面,然後再分析網絡在視(shì)頻(pín)上(shàng)産生的不同特征,用比較成熟的淺層跟蹤算法來進行(xíng)跟蹤,這(zhè)樣利用了(le)深度學習特征學習比較好的好處,同時(shí)又利用了(le)淺層方法速度較快(kuài)的優點。效果是每秒鐘(zhōng)10幀,同時(shí)精度破了(le)記錄。

最新的跟蹤成果是基于Hierarchical Convolutional Feature,由一(yī)個韓國(guó)的科研組提出的MDnet。它集合了(le)前面兩種深度算法的集大成,首先離線的時(shí)候有學習,學習的不是一(yī)般的物(wù)體檢測,也不是ImageNet,學習的是跟蹤視(shì)頻(pín),然後在學習視(shì)頻(pín)結束後,在真正在使用網絡的時(shí)候更新網絡的一(yī)部分。這(zhè)樣既在離線的時(shí)候得到了(le)大量的訓練,在線的時(shí)候又能(néng)夠很(hěn)靈活改變自(zì)己的網絡。